Šta je robots.txt i zašto je važan za SEO?

Šta je datoteka robots.txt?

Datoteke robots.txt mogu se činiti komplikovanim, ali njihova sintaksa (računarski jezik) je jednostavna.

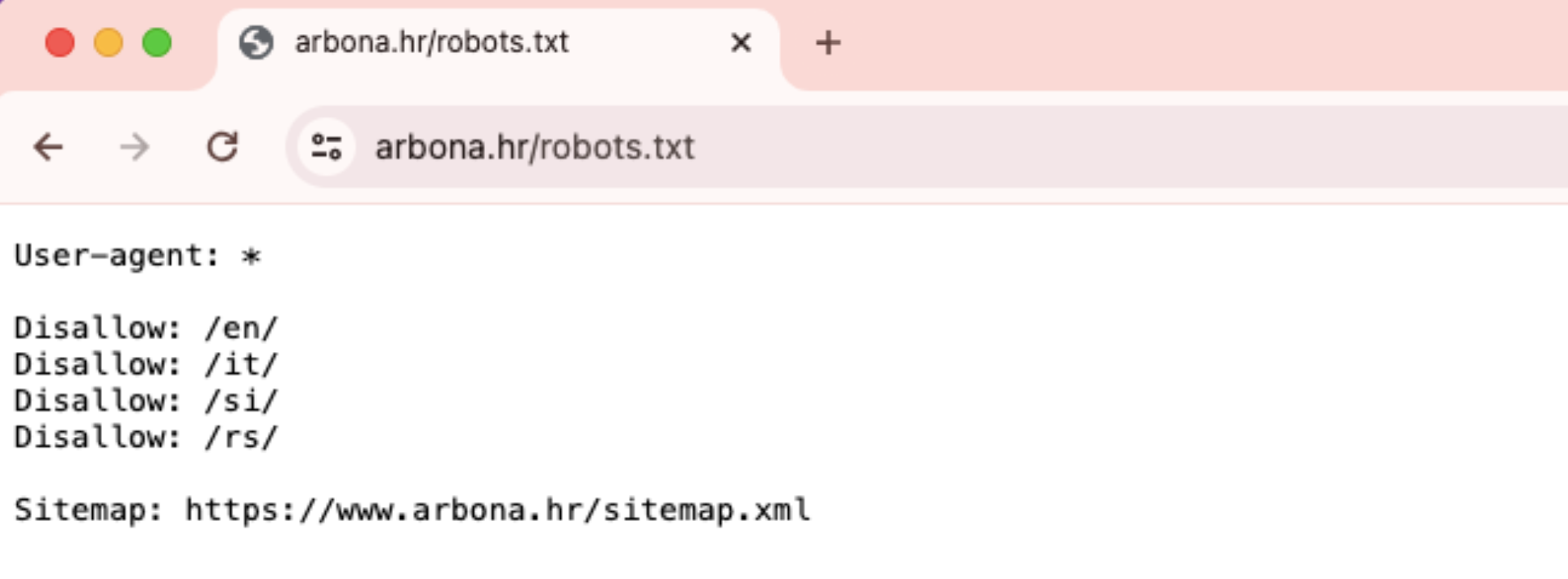

Datoteka robots.txt izgleda ovako:

Zašto je robots.txt važan?

Datoteka robots.txt pomaže u upravljanju aktivnostima veb pretraživača tako da ne preopterete veb-sajt ili ne indeksiraju stranice koje nisu namenjene javnom prikazu.

Evo nekoliko razloga za korišćenje datoteke robots.txt:

Optimizacija proračuna za indeksiranje

Proračun za indeksiranje odnosi se na broj stranica koje će Google indeksirati na vašem veb-sajtu u određenom vremenskom periodu. Broj može varirati u zavisnosti od veličine vašeg sajta, njegovog zdravlja i broja povratnih linkova. Ako broj stranica na vašem veb-sajtu premašuje proračun za indeksiranje, možda ćete imati neindeksirane stranice na svom sajtu. Neindeksirane stranice se neće rangirati, i na kraju, gubite vreme praveći stranice koje korisnici neće videti. Blokiranjem nepotrebnih stranica pomoću robots.txt, omogućujete Googlebot-u (Google-ovom veb pretraživaču) da provodi više vremena indeksirajući važne stranice.

Napomena: Većina vlasnika veb-sajtova ne treba previše brinuti o Google-ovom proračunu za indeksiranje. To je uglavnom zabrinutost za veće sajtove sa hiljadama URL-ova.

Blokiranje duplikata i stranica koje nisu za javnost

Pretraživačima nije potrebno da prolaze kroz svaku stranicu na vašem veb-sajtu, jer nisu sve kreirane za prikaz na stranicama rezultata pretraživača (SERP), kao što su staging stranice, interne stranice rezultata pretrage, duplikat stranice ili stranice za prijavu. Neki sistemi za upravljanje sadržajem sami upravljaju ovim internim stranicama. Na primer, WordPress automatski zabranjuje pristup /wp-admin/ stranici za prijavu svim pretraživačima, a robots.txt vam omogućava da ručno blokirate pristup bilo kojoj stranici vašeg veb-sajta za pretraživače.

Skrivanje resursa

Ponekad želite isključiti resurse kao što su PDF-ovi, videozapisi i slike iz rezultata pretrage kako biste ih zadržali privatnim ili preusmerili Google na važniji sadržaj. U oba slučaja, robots.txt sprečava njihovo indeksiranje.

Kako radi datoteka robots.txt?

Datoteke robots.txt govore botovima pretraživača koje URL-ove mogu indeksirati, a što je još važnije, koje URL-ove treba da ignorišu.

Pretraživači imaju dve glavne svrhe:

Skeniranje veba kako bi otkrili sadržaj

Indeksiranje i dostavljanje sadržaja pretraživačima koji traže informacije

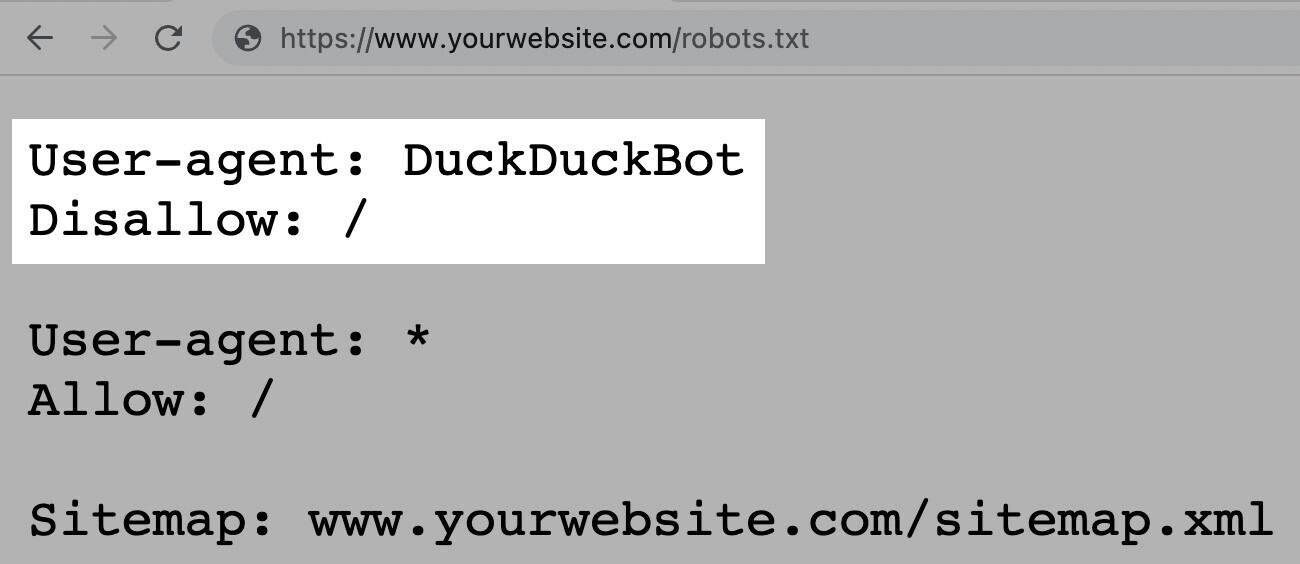

Dok pretražuju veb-sajtove, botovi pretraživača otkrivaju i prate linkove. Ovaj proces ih vodi od mesta A do mesta B do mesta C kroz milione linkova, stranica i veb-sajtova. Međutim, ako bot naiđe na datoteku robots.txt, prvo će je pročitati pre nego što uradi bilo šta drugo. Sintaksa je jednostavna. Pravila se određuju identifikovanjem korisničkog agenta (bot pretraživača), a zatim sledi uputstva (pravila). Takođe možete koristiti zvezdicu (*) kao džoker za dodelu uputstava svakom korisničkom agentu, što se odnosi na pravilo za sve botove.

Na primer, sledeća uputstva omogućavaju svim botovima osim DuckDuckGo da indeksiraju vaš sajt:

Napomena: Iako datoteka robots.txt daje uputstva, ona se ne mogu prisilno sprovesti. Možete je smatrati kao kodeks ponašanja. Dobri botovi (kao što su botovi pretraživača) će pratiti pravila, ali loši botovi (kao što su spam botovi) će ih ignorisati.

Kako pronaći datoteku robots.txt?

Datoteka robots.txt nalazi se na vašem serveru, baš kao i bilo koji drugi fajl na vašem veb-sajtu. Proverite datoteku za bilo koji veb-sajt tako što ćete upisati punu URL adresu početne stranice, a zatim dodati "/robots.txt", kao u ovom primeru: https://www.tiktok.com/robots.txt

.png?vel=226988)

Napomena: Datoteka robots.txt uvek treba da bude locirana na nivou korenskog domena. Za www.tiktok.com, datoteka robots.txt se nalazi na www.tiktok.com/robots.txt. Ako je postavite negde drugde, pretraživači mogu pretpostaviti da je nemate.

Pre nego što naučimo kako da kreiramo datoteku robots.txt, pogledajmo njenu sintaksu koja se sastoji od:

Jednog ili više blokova "uputstava" (pravila)

Svaki sa određenim "user-agent" (bot pretraživača)

I uputstvom "allow" ili "disallow"

Prva linija svakog bloka uputstava je korisnički agent koji identifikuje pretraživača.

Napomena: Većina pretraživača ima više pretraživača. Koriste različite pretraživače za standardno indeksiranje, slike, videozapise itd. Kada je prisutno više uputstava, bot može izabrati najspecifičniji blok uputstava koji je dostupan. Pretpostavimo da imate tri seta uputstava: jedan za *, jedan za Googlebot, i jedan za Googlebot-Image. Ako korisnički agent Googlebot-News pretražuje vaš sajt, slediće uputstva za Googlebot. S druge strane, korisnički agent Googlebot-Image će slediti specifičnija uputstva za Googlebot-Image.

Druga linija direktive robots.txt je linija "Disallow".

Možete imati više direktiva "Disallow" koje specificiraju koje delove vašeg sajta pretraživač ne može pristupiti. Prazna linija "Disallow" znači da ne zabranjujete ništa—pretraživač može pristupiti svim delovima vašeg sajta.

Napomena: Direktive poput "Allowi" i "Disallow" nisu osetljive na velika i mala slova. Međutim, vrednosti unutar svake direktive jesu. Na primer, /photo/ nije isto što i /Photo/. Ipak, često ćete naći da su direktive "Allowi" i "Disallow" napisane velikim slovima kako bi datoteka bila lakša za čitanje ljudima.

"Allow" direktiva

Direktiva "Allowi" omogućava pretraživačima da indeksiraju poddirektorij ili određenu stranicu, čak i unutar direktorija koji je inače zabranjen.

Napomena: Ne prepoznaju svi pretraživači ovu komandu. Međutim, Google i Bing podržavaju ovu direktivu.

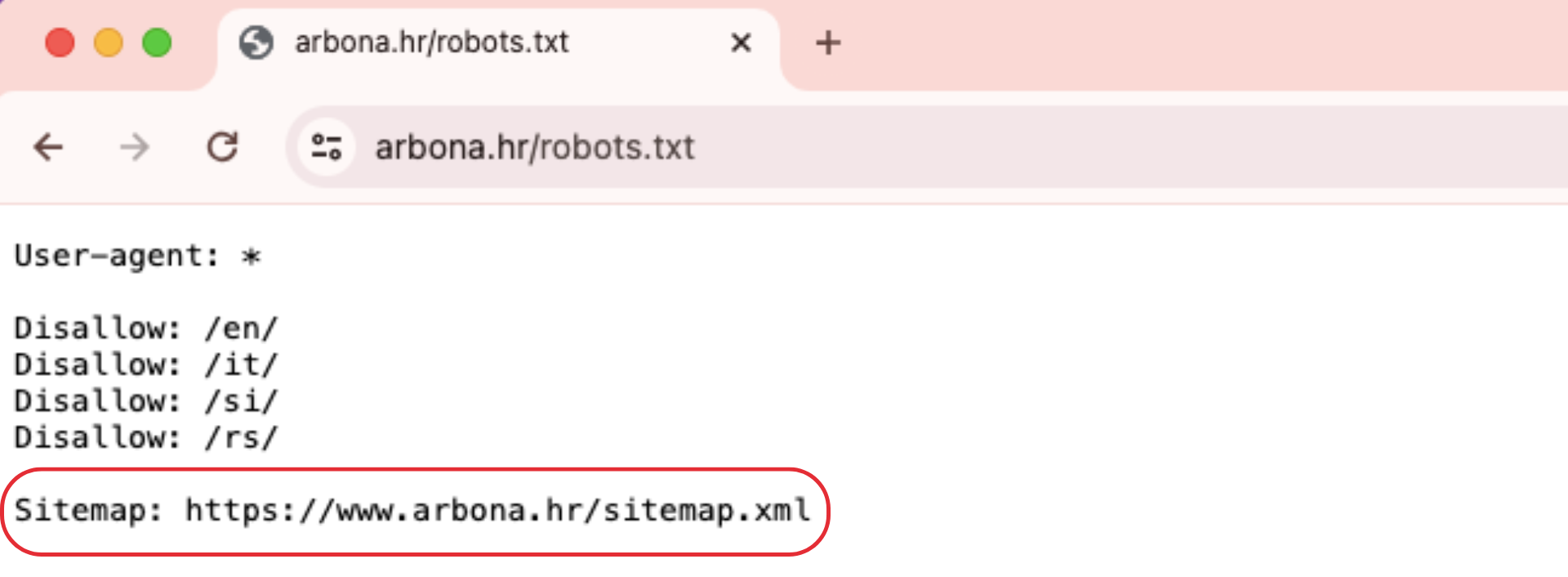

Direktiva Sitemap

Direktiva Sitemap govori pretraživačima, posebno Bing-u, Yandex-u i Google-u, gde mogu pronaći vaš XML sitemap. Sitemape obično uključuju stranice koje želite da pretraživači indeksiraju i nalaze se na vrhu ili dnu datoteke robots.txt i izgledaju ovako:

Dodavanje direktive Sitemap u vašu datoteku robots.txt je brza alternativa. Međutim, trebali biste (i morate) takođe poslati svoj XML sitemap svakom pretraživaču koristeći njihove alate za vebmastere. Pretraživači će na kraju indeksirati vaš sajt, ali slanje sitemapa ubrzava proces indeksiranja.

Direktiva Crawl-Delay

Direktiva Crawl-Delay nalaže pretraživačima da odlože svoje stope indeksiranja kako bi izbegli preopterećenje servera (npr. usporavanje vašeg veb-sajta). Google više ne podržava direktivu Crawl-Delay. Ako želite postaviti svoju stopu indeksiranja za Googlebot, moraćete to uraditi u Search Console. Bing i Yandex, s druge strane, podržavaju direktivu Crawl-Delay.

Direktiva Noindex

Datoteka robots.txt govori botu šta može ili ne može indeksirati, ali ne može reći pretraživaču koje URL-ove ne treba indeksirati i ne prikazivati u rezultatima pretrage. Google nikada zvanično nije podržao ovu direktivu, ali 1. septembra 2019. Google je objavio da ova direktiva nije podržana.

Ako želite pouzdano isključiti stranicu ili datoteku iz pojavljivanja u rezultatima pretrage, izbegavajte ovu direktivu u potpunosti i koristite meta robotse noindex tag.

Kako kreirati datoteku robots.txt

Možete koristiti alat za generisanje datoteke robots.txt ili je sami kreirati.

Kreirajte datoteku i nazovite je Robots.txt. Počnite tako što ćete otvoriti .txt dokument u tekst editoru ili veb pretraživaču. Ne koristite tekst editor koji čuva datoteke u svom formatu, jer mogu dodati nasumične karaktere. Zatim nazovite dokument robots.txt. Sada ste spremni da počnete unositi direktive.

Dodajte direktive u datoteku Robots.txt. Datoteka robots.txt sastoji se od jedne ili više grupa direktiva, svaka grupa se sastoji od nekoliko redova uputstava. Svaka grupa počinje sa "user-agent" i sadrži sledeće informacije:

Kome se grupa odnosi (user-agent)

Koje direktorije (stranice) ili datoteke agent može pristupiti

Koje direktorije (stranice) ili datoteke agent ne može pristupiti

Sitemap (opciono) kako biste rekli pretraživačima koje stranice i datoteke smatrate važnim

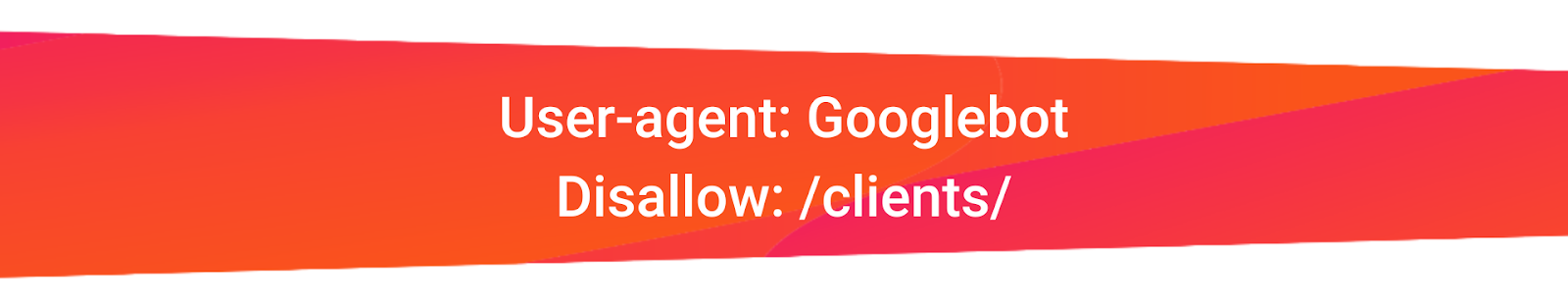

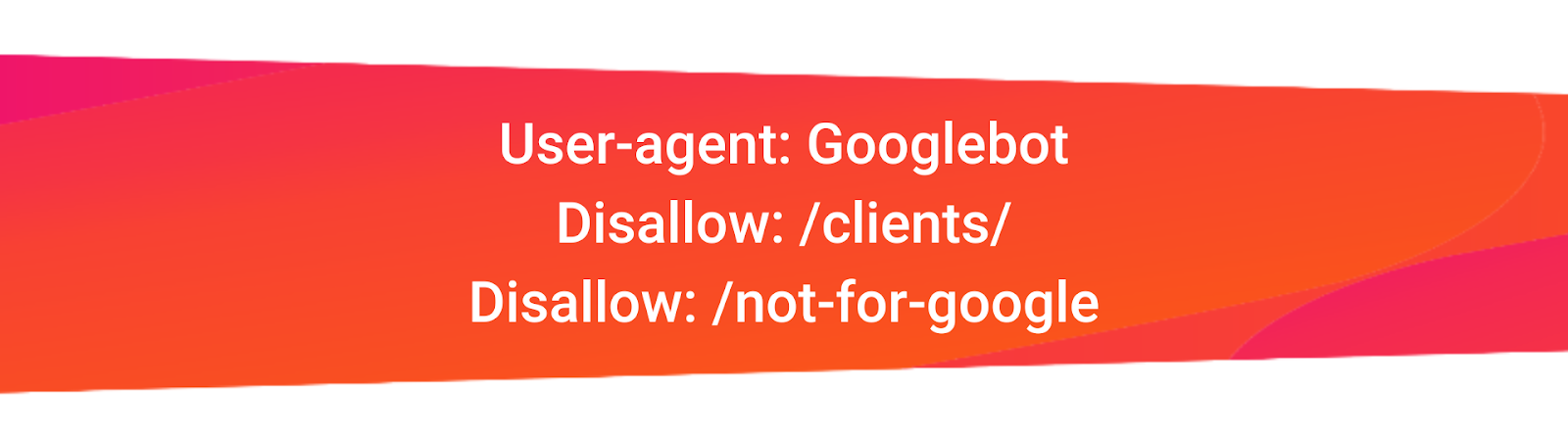

Pretraživači ignorišu redove koji ne odgovaraju ovim direktivama. Na primer, pretpostavimo da ne želite da Google indeksira vaš direktorij /clients/ jer je namenjen samo za internu upotrebu.

Prva grupa bi izgledala ovako:

Dodatne upute mogu se dodati u zasebnom redu ispod, ovako:

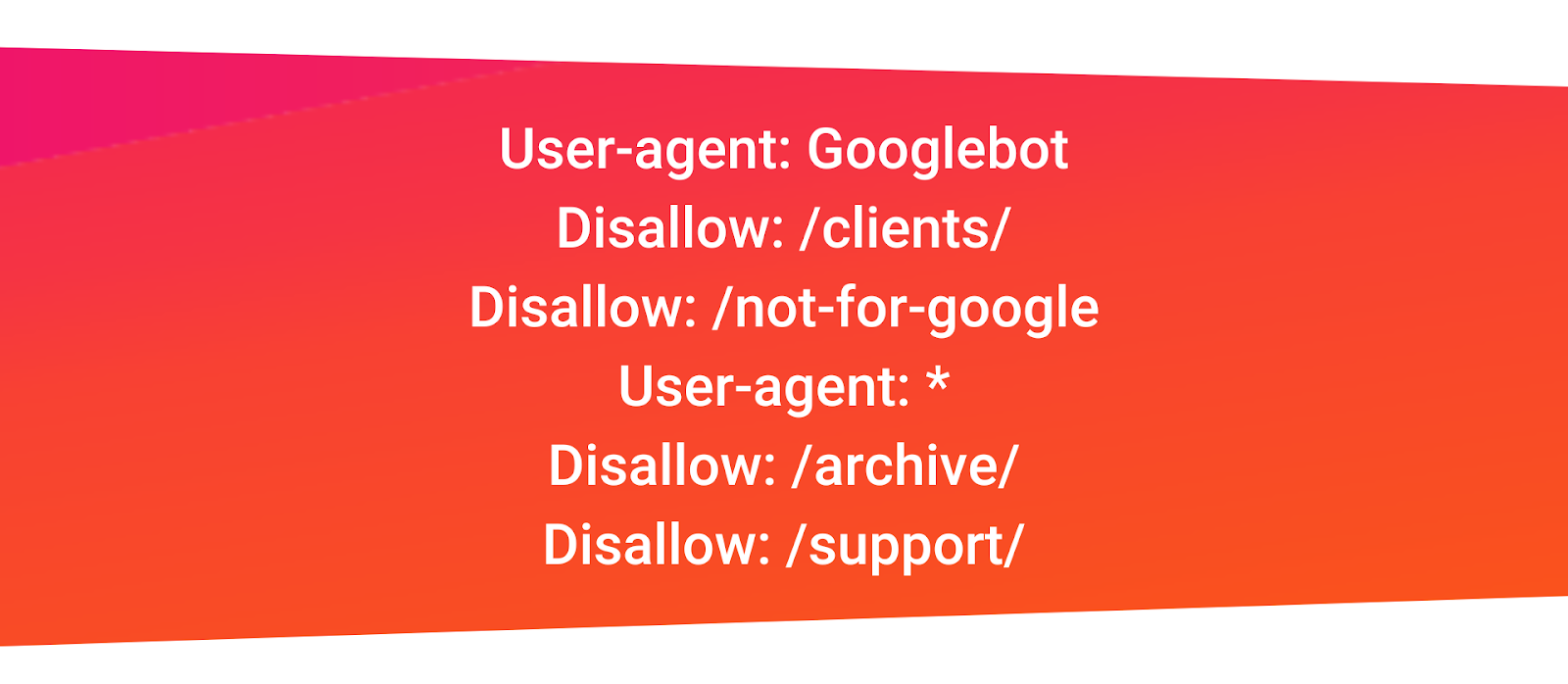

Kada završite sa Google-specifičnim uputama, pritisnite enter dva puta da biste kreirali novu grupu direktiva. Napravimo ovu za sve pretraživače i sprečimo ih da indeksiraju vaše direktorije /archive/ i /support/ jer su namenjeni samo za internu upotrebu.

Izgledalo bi ovako:

Kada završite, dodajte svoj sitemap.

Vaša konačna datoteka robots.txt bi izgledala ovako:

.png?vel=194314)

Sačuvajte svoju datoteku robots.txt.

Napomena: Pretraživači čitaju odozgo nadole i podudaraju se s prvim najspecifičnijim grupama pravila. Stoga, počnite svoju datoteku robots.txt sa specifičnim korisničkim agentima, a zatim pređite na opčenitiji džoker (*) koji odgovara svim pretraživačima.

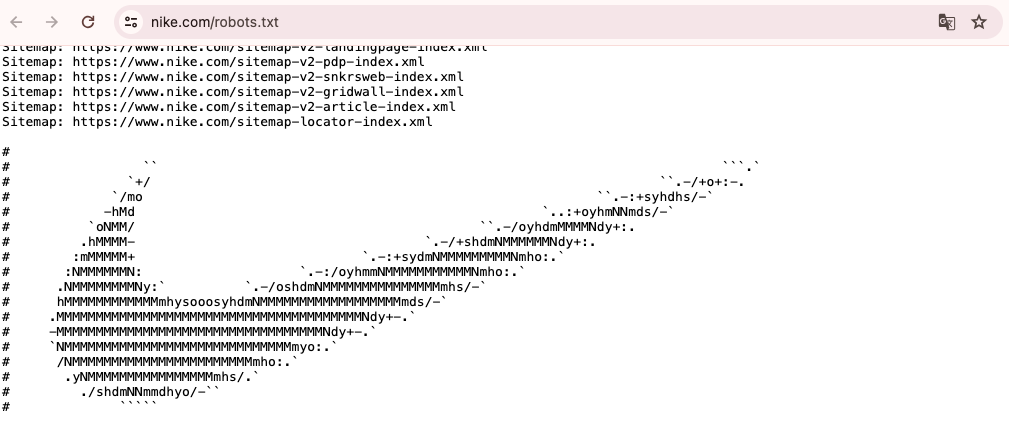

Ako želite ostaviti bilo kakve komentare, prikladno je koristiti # na početku linije. Pošto se ove stranice retko otvaraju, developeri mogu biti malo zaigrani. Tako smo pronašli logo Nike unutar njihove datoteke - https://www.nike.com/robots.txt.

Nakon što ste sačuvali datoteku robots.txt na svom računaru, prenesite je na svoj sajt i učinite je dostupnom za indeksiranje pretraživačima. Transfer datoteke robots.txt zavisi od strukture datoteka vašeg sajta i veb hostinga. Nakon transfera, proverite da li je svima vidljiva i da li je Google može čitati.

Sledeći korak je testiranje. Prvo testirajte da li je vaša datoteka robots.txt javno dostupna (tj. da li je pravilno prenesena). Otvorite privatni prozor u svom pretraživaču i potražite svoju datoteku robots.txt. Ako vidite svoju datoteku sa dodatim sadržajem, spremni ste za testiranje oznake (HTML koda).

Google nudi dve opcije za testiranje oznake robots.txt:

Tester robots.txt u Search Console

Google-ova otvorena biblioteka robots.txt (za napredne)

Pošto je druga opcija namenjena naprednim developerima, testirajmo vašu datoteku robots.txt u Search Console.

Napomena: Morate imati nalog podešen na Google Search Console.

Idite na Robots.txt Tester i kliknite na "Open robots.txt Tester" i otvorite ga. Ako niste povezali svoj veb-sajt sa svojim Google Search Console nalogom, moraćete prvo dodati svojstvo. Zatim, potvrdite da ste stvarni vlasnik sajta.

Ako imate postojeća verifikovana svojstva, izaberite jedno iz padajućeg menija na početnoj stranici. Tester će identifikovati sintaksne ili logičke greške i prikazati ukupan broj upozorenja i grešaka ispod editora. Možete direktno uređivati greške ili upozorenja na stranici i ponovo testirati dok radite.

Sve promene neće biti sačuvane na vašem sajtu, niti alat menja stvarnu datoteku na vašem sajtu, ali testira kopiju u alatu. Da biste sproveli bilo kakve promene, kopirajte i nalepite izmenjenu test kopiju u datoteku robots.txt na vašem sajtu.

Datoteka robots.txt je neophodan alat za svakog vlasnika veb-sajta koji želi upravljati načinom na koji pretraživači indeksiraju njihov sadržaj. Koristeći jednostavnu sintaksu, ova datoteka omogućava vebmasterima da usmeravaju botove pretraživača, instruišući ih koje delove sajta mogu pregledati a koje treba izbegavati. Iako se robots.txt uglavnom koristi da spreči preopterećenje servera i optimizuje budžet za indeksiranje, važno je zapamtiti da ne pruža potpunu privatnost niti može u potpunosti sprečiti indeksiranje ako se ne kombinuje sa drugim metodama kao što su meta tagovi noindex.

Pametna upotreba datoteke robots.txt može značajno poboljšati SEO vašeg sajta usmeravajući botove na važan sadržaj i odvraćajući ih od nepotrebnih ili dupliranih stranica. Za veb-sajtove sa velikim brojem poddomena posebno je važno kreirati odvojene datoteke robots.txt za svaku poddomenu, osiguravajući da botovi pravilno indeksiraju sadržaj na svakoj od njih. Na kraju, pravilno upravljanje i testiranje vaše datoteke robots.txt će osigurati da pretraživači ispravno tumače vaše upute, doprinoseći boljem rangiranju i vidljivosti vašeg veb-sajta na internetu.

Zadnji Blog postovi

Kategorije

Arhiva Blog postova

- Svibanj 2024 (2)

- Travanj 2024 (4)

- Ožujak 2024 (5)

- Siječanj 2024 (6)

- Prosinac 2023 (6)

- Studeni 2023 (5)

- Lipanj 2023 (2)

- Svibanj 2023 (1)

- Travanj 2023 (8)

- Veljača 2023 (1)

- Siječanj 2023 (2)

- Studeni 2022 (3)

- Listopad 2022 (8)

- Rujan 2022 (9)

- Kolovoz 2022 (5)

- Srpanj 2022 (9)

- Lipanj 2022 (9)

- Svibanj 2022 (8)

- Travanj 2022 (8)

- Ožujak 2022 (7)

- Veljača 2022 (6)

- Siječanj 2021 (1)

- Prosinac 2020 (3)

- Studeni 2020 (2)

- Listopad 2020 (5)

- Rujan 2020 (3)

- Kolovoz 2020 (4)

- Srpanj 2020 (7)

- Lipanj 2020 (4)

- Svibanj 2020 (4)

- Ožujak 2020 (5)

- Veljača 2020 (5)

- Siječanj 2020 (4)

- Prosinac 2019 (5)

- Studeni 2019 (7)

- Listopad 2019 (5)

- Rujan 2019 (3)

- Kolovoz 2019 (6)

- Srpanj 2019 (1)

- Lipanj 2019 (2)

- Svibanj 2019 (3)

- Travanj 2019 (3)

- Ožujak 2019 (3)

- Veljača 2019 (3)

- Siječanj 2019 (5)

- Prosinac 2018 (5)

- Studeni 2018 (3)

- Listopad 2018 (5)

- Rujan 2018 (2)

- Kolovoz 2018 (6)

- Srpanj 2018 (6)

- Lipanj 2018 (4)

- Svibanj 2018 (5)

- Travanj 2018 (4)

- Ožujak 2018 (3)

- Veljača 2018 (3)

- Siječanj 2018 (5)

- Prosinac 2017 (4)

- Studeni 2017 (4)

- Listopad 2017 (6)

- Rujan 2017 (1)

- Kolovoz 2017 (4)

- Srpanj 2017 (4)

- Lipanj 2017 (3)

- Svibanj 2017 (3)

- Travanj 2017 (4)

- Ožujak 2017 (4)

- Veljača 2017 (4)

- Siječanj 2017 (2)

- Prosinac 2016 (3)

- Studeni 2016 (3)

- Listopad 2016 (6)

- Rujan 2016 (6)

- Kolovoz 2016 (1)

- Lipanj 2016 (3)

- Svibanj 2016 (3)

- Travanj 2016 (4)

- Ožujak 2016 (3)

- Veljača 2016 (3)

- Siječanj 2016 (3)

- Prosinac 2015 (1)

- Studeni 2015 (4)

- Listopad 2015 (1)

- Rujan 2015 (2)

- Kolovoz 2015 (2)

- Lipanj 2015 (1)

- Svibanj 2015 (4)

- Ožujak 2015 (3)

- Prosinac 2014 (15)

- Studeni 2014 (1)

- Listopad 2014 (7)

- Rujan 2014 (10)

- Kolovoz 2014 (3)

- Srpanj 2014 (3)

- Lipanj 2014 (3)

- Svibanj 2014 (1)

- Travanj 2014 (3)

- Ožujak 2014 (3)

- Veljača 2014 (1)

- Siječanj 2014 (4)